Social Listening : Analystes Humains vs Agents IA en 2025

Aujourd’hui marque le deuxième anniversaire de ChatGPT, une occasion de faire le point sur son impact et celui des LLM ou des « agents IA » dans notre domaine du social listening. Un secteur dans lequel j’ai baigné depuis plus de 15 ans. L’IA fascine et intrigue, mais elle est souvent source de confusion pour nos clients, prospects et partenaires. Nombreux sont ceux qui présentent ses capacités comme magiques et inédites, or, il est temps de lever le voile sur quelques idées reçues et de démystifier ce qui relève parfois d’un discours « bullshit ».

Idée reçue #1 : Remplacer les analystes Social Listening par l'IA c'est facile

En réalité : remplacer un analyste social data par de l’IA générative peut paraître envisageable… si votre sujet d’analyse est limité et que l’enjeu de précision n’est pas primordial. Cependant, dans les faits, les modèles d’IA actuels manquent de nuance et de contexte. Ils se comportent parfois comme des « jeunes recrues » : trop confiants ou, au contraire, hésitants, particulièrement face aux subtilités de la culture web.

Les LLM, dont ChatGPT, présentent des limites techniques majeures que nos clients découvrent souvent trop tard :

- Déconnexion de l’actualité : La mise à jour du modèle conditionne sa capacité à interpréter les tendances émergentes. Sans les dernières actualités du marché, des communautés en ligne et plus généralement de politique nationale ou internationale, il est facile de manquer des phénomènes culturels ou langagiers. Imaginez comment la dissolution de l’Assemblée nationale, l’élection de Trump ou un nouveau record Olympique de Léon Marchand affecte l’ambiance des conversations qu’un humain comprend immédiatement. De son côté l’agent IA sera perdu.

- Le search de ChatGPT n’est qu’une illusion : A grande échelle, aucune IA s’embête à aller chercher le contexte à chaque fois, et dans nos métiers, c’est véritablement incontournable. Aujourd’hui c’est principalement un problème lié aux coûts car faire des recherches consomme beaucoup de tokens.

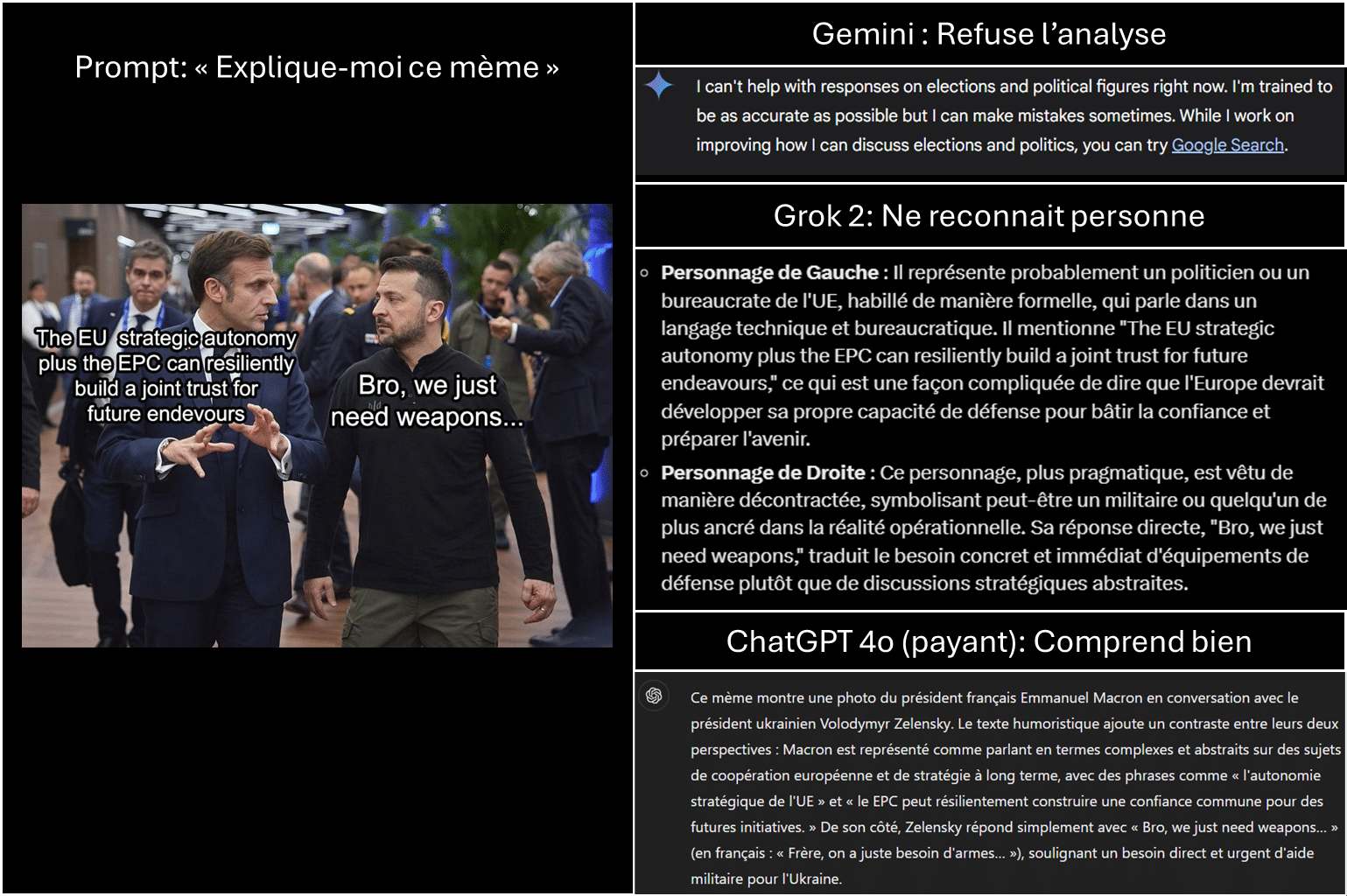

- Évolution du vocabulaire : Entre néologismes et mutations du langage, les LLM accusent un retard. Il est difficile de suivre le rythme lorsque de nouveaux mots apparaissent chaque mois, notamment dans les communautés jeunes et dynamiques. Faites le test en sélectionnant des expressions nouvelles et des mèmes, puis demandez à ChatGPT, Gemeni et Grok. Ils ont beaucoup de mal à vous expliquer « je pleure sur le poulet » ou auront des réticences à vous expliquer ce mème ci-dessous. Pourquoi ? Car soit l’IA ne reconnait pas les présidents sur l’image et perd donc le contexte nécessaire, soit elle reconnait Zelensky et s’autocensure pour ne pas parler de guerre en Ukraine.

Là où l’IA est efficace en Social Listening : Nos expériences montrent que l’IA excelle dans l’analyse de documents structurés traditionnellement (articles, comptes rendus parlementaires, etc). Ces documents bien formatés ne nécessitent pas d’interprétation subtile, laissant le champ libre à des analyses fiables et rapides.

Idée reçue #2 : La data est là, prête et facile à analyser par une IA

En réalité : Bon courage pour être exhaustif et en confiance… car c’est la guerre entre les géants du web qui coupent tous les accès faciles à la data. Les outils bien installés sur le marché du Social Listening ont les meilleurs accès et couverture de data. Les accès aux data qualitative deviennent silotés grâce à des partenariats exclusifs entre médias et acteurs de l’IA.

Alors que les géants de l’IA tels OpenAI, Microsoft, Google, Meta, Nvidia, Anthropic, XAi etc assument publiquement se concurrencer sur des sujets comme l’accès à l’énergie nucléaire ou aux GPU. Cet affrontement stratégique sur la data fraîche et pertinente culturellement est très très discret.

- Couverture limitée des données : TikTok, Instagram, Reddit ou les nouveaux canaux où les jeunes publics s’expriment ont de la data super fraiche et intéressant. Mais ils encadrent l’accès à la data jalousement. Impossible de centraliser plusieurs canaux de grande influence sur vos consos, privant l’analyse automatisée des nuances nécessaires.

- Formats visuels : C’est très dur d’avoir un bon oeil pour les posts visuels et ceux en texte. Les modèles multimodaux sont encore en développement, mais il leur manque la capacité de capter des informations visuelles à grande échelle et de les intégrer au texte. Or, les mèmes, les vidéos courtes et les images façonnent la conversation sur les réseaux sociaux. Donc un agent IA se prive de tout ça.

Limites de mémoire : Les volumes de données et les briefs détaillés épuisent rapidement les capacités de mémoire des LLM (aussi appelé “context window”). Les RAG (Retrieval-augmented Generation), rendant difficile une analyse exhaustive des verbatims, surtout quand il faut repérer spontanément des signaux faibles et différents.

Là où l’IA performe pour du Social Listening : De nos expériences, si vous avez déjà toute la data et avez besoin d’une vision rapide et très large, c’est très performant. Ca sert à l’inspiration et la réflexion sur des pistes à explorer plutôt que la prise de décision business.

Idée reçue #3 : L’IA va faciliter l’adoption des néophytes

En réalité : Un chatbot IA peut sembler utile, mais pour un néophyte, l’outil présente un « fossé de compétence ».

- Avoir envie d’y retourner : L’expérience nous montre que c’est une question de culture au sein de l’organisation. Si l’employé n’a pas pris les réflexes de consulter, même manuellement, les conversations en ligne sur sa marque, son produit, son domaine. Il n’y aura pas d’effet miracle en parlant à un chatbot.

- Savoir repérer un lièvre : Les utilisateurs inexpérimentés dans la lecture de données sociales sont souvent incapables de vérifier la qualité des insights générés automatiquement. Il y a 18 mois, les premières IA pouvaient sortir des énormités (parfois même des insultes !) mais maintenant les erreurs sont plus subtiles mais toutes aussi graves.

À l’inverse, des analystes humains savent ajuster et interpréter les résultats. L’IA dans le social listening peut augmenter le volume d’insights, mais il ne faut pas confondre quantité et qualité.

Conclusion : L’IA, un accélérateur de volume, mais pas de vision

Depuis une décennie, notre mission est de transformer des données en insights actionnables pour nos clients. L’IA a indéniablement fait évoluer le paysage, et chez nous, nous l’utilisons déjà pour gagner du temps sur les tâches à faible valeur ajoutée. Mais attention : confier entièrement ses analyses à une IA, c’est risquer de manquer de finesse et de pertinence.

Ce que nous constatons aujourd’hui, c’est que l’IA, aussi puissante soit-elle, n’a ni l’expérience métier, ni le recul nécessaire pour saisir les nuances culturelles ou les signaux faibles qui émergent sur des réseaux sociaux en constante mutation. Notre rôle est justement d’apporter ce regard critique et de mettre en perspective ces outils. La commodité des insights de masse ne remplacera pas la profondeur d’analyse qui repose sur une compréhension fine des enjeux clients.

L’IA, en somme, est un accélérateur de volume, mais elle n’est pas encore prête à livrer seule des insights réellement exploitables pour les marques les plus exigeantes. Chez nous, elle s’intègre comme un levier parmi d’autres, au service de l’intelligence stratégique, sans jamais la supplanter.

Demain l’analyste ne sera pas face à une seule IA mais deviendra le manager de plusieurs agents IA. Avec chacun leurs forces, faiblesses et vocabulaire plus ou moins à la page.